Roeland Hofkens, Chief Product & Technology Officer, LanguageWire

Roeland Hofkens, Chief Product & Technology Officer, LanguageWire

Grote taalmodellen (Large Language Models of kortweg LLM's) hebben de wereld veroverd.

Sommige van deze modellen, zoals de GPT-4 van OpenAI en PaLM2 van Google, zijn getraind in een meertalige gegevensset en zouden – althans in theorie – ook zeer geschikt moeten zijn voor machinevertaling.

Maar is dit wel zo? Hoe kunnen we het volledige potentieel van LLM's voor machinevertaling benutten? In deze blog nemen we een frisse duik in de technische werking van LLM's op het vlak van machinevertaling en hoe ze kunnen worden geïntegreerd in een Translation Management System (TMS).

De meeste van de huidige tools voor machinevertaling, zoals Google Translate, zijn gebaseerd op neurale modellen met een transformatorarchitectuur. Deze modellen zijn speciaal ontworpen voor één taak: machinevertaling. Out-of-the-box leveren ze heel goede prestaties voor vertaalopdrachten die redelijk algemene content omvatten. In gespecialiseerde bedrijfscontexten bestaat echter het risico dat ze de juiste woordenschat missen of een suboptimale stijl gebruiken.

Daarom is het zinvol om deze modellen aan te passen met aanvullende bedrijfsgegevens door ze te trainen om je persoonlijke termen en zinnen te herkennen. Met behulp van verschillende maatwerktechnieken leert het model de tone of voice en terminologie van je bedrijf te gebruiken, wat dan weer leidt tot betere machinevertalingen

Grote taalmodellen zijn meestal ook gebaseerd op transformatorarchitecturen. Ten opzichte van de Neurale Machinevertalingen (NMT) die we bespraken in de vorige post zijn ze echter getraind in veel grotere tekstdelen en bevatten ze meer modelparameters. LLM's bevatten miljarden parameters tegenover enkele honderden miljoenen in tweetalige NMT-modellen met enkelvoudige taken. Dit maakt LLM-modellen soepeler en 'slimmer' als het gaat om het interpreteren van gebruikersinstructies of 'prompts'. Deze nieuwe technologie biedt heel wat nieuwe perspectieven om modellen op maat te maken op basis van bedrijfsgegevens. Omdat deze aanpak zo sterk is, zou ik zelfs eerder spreken over 'personalisatie'. Laten we eens kijken hoe deze personalisatie precies werkt.

Bij het gebruik van LLM's zijn er in principe twee manieren om het model nauwkeuriger af te stemmen zodat het bij inferentie een respons van betere kwaliteit genereert.

Laten we eerst de parameterafstemming van naderbij bekijken.

Parameters van een LLM bijwerken kan een lastige taak zijn. Vergeet niet dat zelfs kleine LLM's miljarden parameters hebben. Al die parameters aanpassen vraagt extreem veel rekenkracht. De complexiteit en vooral de kostprijs ervan liggen gewoonlijk buiten het bereik van de doorsnee consument.

Voor machinevertalingen beginnen we gewoonlijk met een op instructies afgestemde LLM. Dit is een handzamer model dat verfijnd is om instructies op te volgen, in plaats van alleen de volgende woorden te voorspellen. Na het afstemmen zal het model beter presteren bij uiteenlopende taken, zoals samenvatten, classificeren en machinevertaling. In toekomstige blogposts in deze reeks zullen we meer informatie geven over welk model je moet kiezen.

De op instructie afgestemde LLM's zijn alvast een goed uitgangspunt voor verdere klantspecifieke optimalisaties. Met behulp van Parameter Efficient Fine-Tuning of PEFT kunnen we een geïnstrueerd model met klantgegevens op een korte, meer kosteneffectieve manier finetunen.

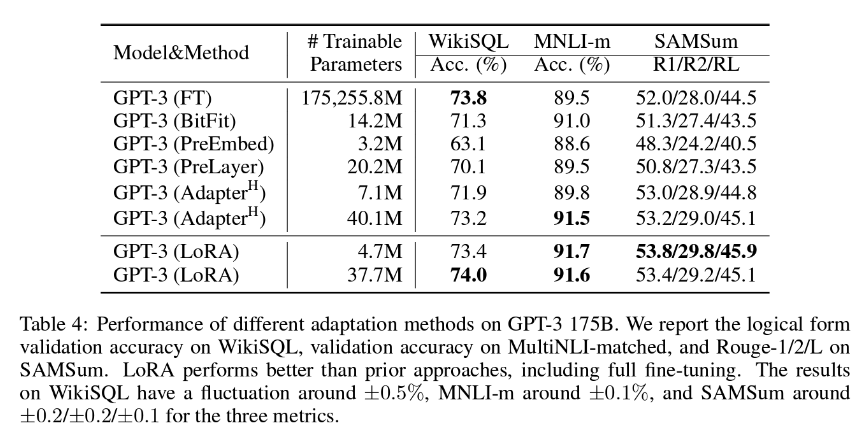

Bij LanguageWire gaat de voorkeur uit naar de PEFT-methode LoRA (Low-Rank Adaption), die meestal het updaten van ongeveer 1,4 tot 2,0% van de modelgewichten inhoudt. Dit betekent dat de inspanningen voor aanpassing redelijk blijven, maar ook verrassend effectief zijn. Zoals je in de onderstaande tabel kunt zien, besluiten de auteurs van de paper over LoRA dat deze techniek zelfs effectiever kan zijn dan een volledige afstemming van alle modelparameters!

Voor het beste resultaat met deze methode hebben we toegang nodig tot een grote hoeveelheid hoogwaardige leergegevens met bijhorende bron- en doelteksten. Als je al een omvangrijk vertaalgeheugen hebt opgebouwd, kun je dat waarschijnlijk voor dit doel gebruiken. Het AI-team van LanguageWire werkt voortdurend aan het bepalen van de optimale grootte van het vertaalgeheugen voor LoRA-tuning.

Laten we nu verder gaan met de tweede aanpak, in-context of few-shot learning.

In-context learning is een methode waarbij het model in een oogwenk leert uit een klein aantal voorbeelden die worden geïntroduceerd door een speciaal gemaakte prompt. Dit staat ook bekend als few-shot learning.

In het kader van Machinevertaling werkt few-shot learning als volgt:

Few-shot learning voor MT heeft een positieve invloed op de vloeiendheid, tone of voice en de naleving van terminologie. Er zijn minder voorbeelden nodig om mee te werken, maximaal drie tot vijf. Sterker nog, meer voorbeelden toevoegen maakt de zaak niet efficiënter. Een heel vertaalgeheugen toevoegen in een enkele prompt heeft hier dus weinig zin. Experimenten hebben namelijk aangetoond dat LLM's niet erg goed omgaan met grote promptcontexten en dat de kwaliteit van de resultaten zelfs kan verslechteren.

Door de combinatie van de voordelen van LoRA en few-shot learning kunnen we sterke optimalisaties doorvoeren in het Large Language Model, wat uiteindelijk leidt tot hypergepersonaliseerde machinevertaling van topkwaliteit.

Geen van deze technieken zou werken zonder een grote set hoogwaardige, up-to-date tweetalige tekstcorpora in verschillende taalcombinaties. Jouw vertaalgeheugens zijn de perfecte bron voor deze gegevensset.

Voordat je ze echter kunt gebruiken, moet je een aantal belangrijke aspecten in overweging nemen:

Als je het LanguageWire-platform gebruikt, zorgt een geautomatiseerde module voor het vertaalgeheugenbeheer en hoef je zelf geen handmatige acties te ondernemen.

Mocht je een bestaand extern vertaalgeheugen willen gebruiken in combinatie met ons platform en machinevertaling, dan kunnen onze technici dit mogelijk maken. De technici van LanguageWire hebben API's voor importeren, scripts voor opschonen en tools voor taalkwaliteitsbeoordeling ontwikkeld om je te helpen je meest waardevolle assets optimaal te benutten.

Hoe kunnen we dit alles samenbrengen voor een typisch vertaalproject? Laten we eens kijken naar een voorbeeld.

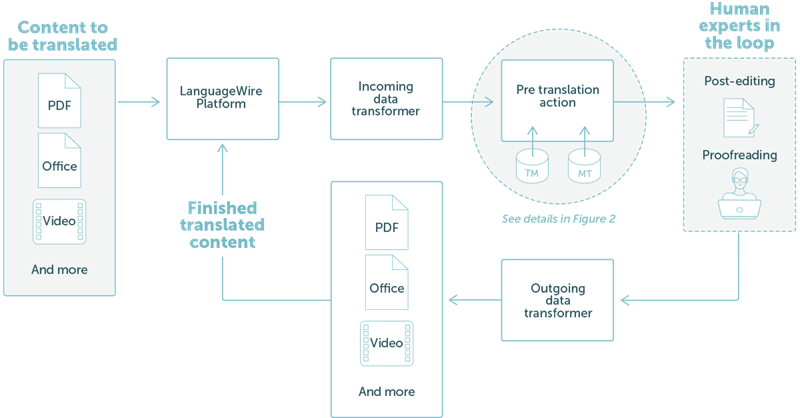

LanguageWire biedt een oplossing die volledig is geïntegreerd in ons technologiesysteem. Dit wordt overzichtelijk weergegeven in afbeelding 1 hieronder.

In dit voorbeeld hebben we een eenvoudige workflow genomen waarbij een klant PDF- of Office-bestanden wil omzetten. De gebruiker uploadt de contentbestanden gewoon via het projectportaal van LanguageWire. Van daaruit wordt alles automatisch georganiseerd:

AFBEELDING 1: Een eenvoudig vertaalproject in het bestaande LanguageWire-platform resultaat

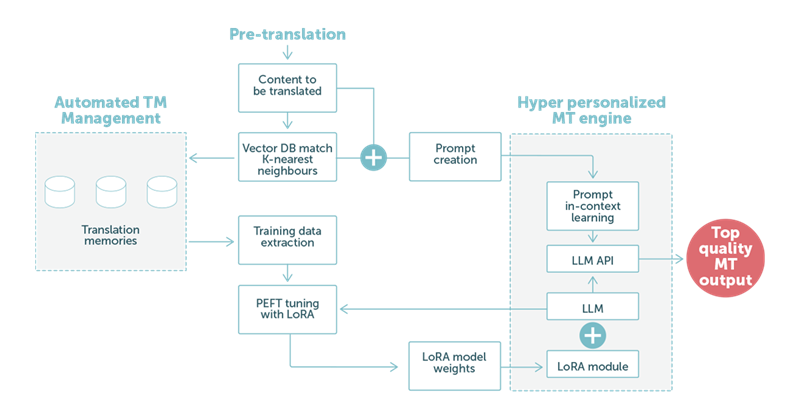

In het tweede voorbeeld gaan we dieper in op de voorvertaling met behulp van machinevertaling op basis van LLM-technologie. Zoals we in Afbeelding 2 hieronder zien, spelen de taaldata van de klant een centrale rol.

AFBEELDING 2: Een voorbeeld van een vertaling met behulp van een Large Language Model met een mix van LoRA-aanpassing en optimale in-context learningprompts.

Wanneer de LLM onze speciaal gemaakte prompt behandelt, dragen de aangepaste gewichten in de LoRA-module bij aan een machinevertaling van topkwaliteit. Zodra dit is voltooid, gaat deze output automatisch naar de volgende stap in het proces. Dit is meestal een post-editingtaak met een menselijke expert die zorgt voor maximale eindkwaliteit.

Samengevat: onze klanten kunnen rekenen op nog betere machinevertaling. Machinevertaling kan zich automatisch aanpassen aan verschillende contexten, bijvoorbeeld verschillende business verticals, en afstemmen op de verwachte tone of voice en woordkeuze van die vertical.

Dit verlaagt niet alleen de kosten van post-editing, maar verhoogt ook de leveringssnelheid van vertalingen. Het geeft onze klanten ook mogelijkheden om de MT-output rechtstreeks te gebruiken, zonder menselijke experts te moeten inschakelen.

Zoals we al zeiden, zijn Large Language Models erg flexibel. Het AI-team van LanguageWire onderzoekt tal van andere use cases waarvoor we LLM-technologie kunnen inzetten.

We onderzoeken momenteel:

De geautomatiseerde toetsing van de taalkwaliteit. Het LLM kan de vertaling van een menselijke expert of de machinevertaling van een ander model controleren en een kwaliteitsscore geven. Dit kan de kosten voor proeflezing aanzienlijk verlagen. De basistechnologie voor Machine Translation Quality Estimation (MTQE) kan ook worden toegepast op andere use cases.

Content authoring assistants. Met een combinatie van PEFT met LoRA en few-shot learning kunnen we het LLM-model personaliseren om zodat het ook kan worden gebruikt voor contentcreatie. Een klant kan zoekwoorden en metagegevens leveren waarmee het model een tekst kan genereren die gebruikmaakt van een zakelijke, op maat gemaakte woordkeuze en tone of voice.

Het LLM verder personaliseren met gegevens uit termbases.

Er is nog veel meer op komst. Dat lees je hier de komende weken in nieuwe blogposts over AI en de toekomst van LLM's bij LanguageWire.

Andere interessante artikelen

Jouw weg naar een krachtig, naadloos taalbeheer begint hier! Laat ons weten wat jij nodig hebt en wij bedenken de beste oplossing voor jouw onderneming.