Roeland Hofkens , Chief Product & Technology Officer, LanguageWire

Roeland Hofkens , Chief Product & Technology Officer, LanguageWire

Los grandes modelos de lenguaje (LLM, por sus siglas en inglés) han conquistado el mundo.

Algunos de estos modelos, como el GPT-4 de OpenAI y el PaLM2 de Google, se han entrenado con conjuntos de datos multilingües y, al menos en teoría, también deberían ser muy capaces de realizar tareas de traducción automática.

Pero ¿es realmente así? ¿Cómo podemos aprovechar el potencial de los grandes modelos de lenguaje para la traducción automática? En este análisis técnico, veremos cómo funcionan los LLM en el ámbito de la traducción automática y cómo podrían integrarse en un sistema de gestión de traducciones (TMS, por sus siglas en inglés).

La mayoría de las herramientas comerciales actuales de traducción automática, como el Traductor de Google, se basan en modelos neuronales con una estructura de transformador. Estos modelos están diseñados específicamente para acometer una tarea: la traducción automática. Desde un primer momento, ya rinden muy bien en las tareas necesarias para traducir contenido genérico. Sin embargo, en contextos empresariales especializados, puede que no utilicen el vocabulario adecuado o que su estilo no sea el mejor.

Por lo tanto, resulta útil adaptar estos modelos con datos empresariales adicionales, entrenándolos para que reconozcan términos y frases específicos. Mediante el uso de varias técnicas de adaptación, el modelo «aprende» a utilizar el tono de voz y la terminología de una determinada empresa para, a continuación, generar mejores resultados de traducción automática.

Los grandes modelos de lenguaje suelen basarse también en estructuras de transformadores. Sin embargo, en comparación con los modelos de traducción automática neuronal (NMT, por sus siglas en inglés) del apartado anterior, se entrenan con volúmenes de texto mucho más extensos y contienen más parámetros del modelo. Los LLM contienen miles de millones de parámetros frente a los pocos cientos de millones de los modelos de NMT bilingües de una sola tarea. Esto hace que los modelos LLM sean más flexibles e «inteligentes» a la hora de interpretar las instrucciones o los «mensajes» del usuario. Esta nueva tecnología abre numerosas posibilidades en términos de adaptación de los modelos mediante el uso de datos empresariales. Dada la potencia de este planteamiento, prefiero hablar en términos de «personalización» en lugar de «adaptación». Veamos cómo funciona esta personalización.

Cuando se utilizan LLM, existen dos planteamientos para ajustar el modelo con el fin de que produzca una mejor calidad en el momento de la inferencia, en el momento en que genera su respuesta.

Veamos primero el ajuste de parámetros.

Actualizar los parámetros de un LLM puede ser una tarea abrumadora. Recuerda que hasta los LLM pequeños tienen miles de millones de parámetros. Actualizarlos es una tarea computacionalmente muy costosa que suele estar fuera del alcance de un consumidor medio, ya que el coste y la complejidad de hacerlo son demasiado elevados.

Para la traducción automática, empezaremos con un modelo LLM ajustado a una serie de instrucciones. Se trata de un modelo que se ha ajustado para ser más útil y seguir instrucciones, en lugar de simplemente predecir las siguientes palabras. Después del ajuste, el modelo realizará mejor una gran variedad de tareas, como resumir, clasificar y traducir de forma automática. En futuras publicaciones de esta serie del blog, ofreceremos más información sobre qué modelo elegir.

Los LLM ajustados a las instrucciones son un buen punto de partida para otras optimizaciones específicas del cliente. Mediante el uso de un enfoque llamado Parameter Efficient Fine-Tuning o PEFT (ajuste eficiente de los parámetros), podemos ajustar un modelo instruido con los datos del cliente de forma rápida y más rentable.

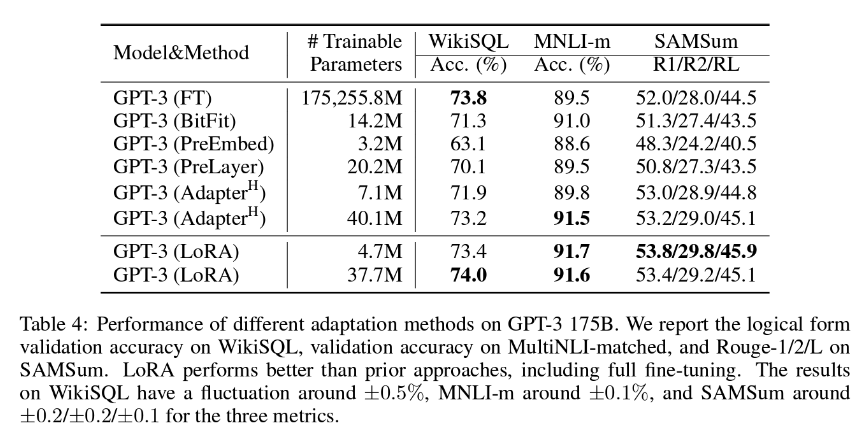

En LanguageWire, nuestro método PEFT preferido es LoRA (Low-Rank Adaption, adaptación de bajo nivel), que normalmente implica la actualización del 1,4-2,0 % de los pesos del modelo. Esto significa que el esfuerzo de adaptación es razonable, pero también sorprendentemente efectivo. Como se puede ver en la siguiente tabla, los autores del artículo sobre LoRA concluyen que la adaptación de bajo nivel puede resultar incluso más efectiva que el ajuste completo de todos los parámetros del modelo.

Para obtener los mejores resultados de este método, necesitamos tener acceso a una gran cantidad de datos de entrenamiento de alta calidad con textos de origen y destino coincidentes. Si ya has creado una memoria de traducción de tamaño considerable, es probable que la puedas utilizar para este fin. El equipo de IA de LanguageWire trabaja constantemente para determinar el tamaño idóneo de la memoria de traducción para el ajuste LoRA.

Pasemos ahora al segundo planteamiento, el aprendizaje de contexto o con pocos ejemplos.

El aprendizaje de contexto es un método en el que el modelo aprende sobre la marcha a partir de unos pocos ejemplos que presenta un mensaje elaborado para este fin. También se conoce como aprendizaje con pocos ejemplos.

En el marco de la traducción automática, el aprendizaje con pocos ejemplos funciona de la siguiente manera:

El aprendizaje con pocos ejemplos para la TA tiene un efecto positivo en la fluidez, el tono de voz y la conformidad con la terminología del texto. Se necesitan pocos ejemplos para trabajar, un máximo de tres a cinco. De hecho, la eficiencia no mejora con muestras de mayor tamaño, por lo que incluir toda la memoria de traducción en un único mensaje no reporta ningún beneficio. Los experimentos han demostrado que los LLM no gestionan muy bien los contextos grandes y que la calidad de los resultados puede incluso deteriorarse.

Combinando los beneficios de la adaptación de bajo nivel y el aprendizaje con pocos ejemplos, podemos aplicar optimizaciones potentes en el gran modelo de lenguaje que, en última instancia, dan como resultado una traducción automática hiperpersonalizada y de alta calidad.

Ninguna de estas técnicas funcionaría sin un gran conjunto de textos bilingües actualizados y de alta calidad en varias combinaciones de idiomas. Tus memorias de traducción son el lugar perfecto del que extraer este conjunto de datos.

Sin embargo, antes de poder utilizarlas, debes tener en cuenta varios aspectos importantes:

Si utilizas la plataforma de LanguageWire, el módulo automatizado de gestión de memorias de traducción se ocupa de ello por ti y no necesitas efectuar ninguna acción manual.

En el caso de que dispongas de una memoria de traducción externa que quieras utilizar con nuestra plataforma y nuestros servicios de traducción automática, nuestros técnicos pueden hacerlo posible. Los técnicos de LanguageWire han creado diversas API de importación, scripts de limpieza y herramientas de evaluación de la calidad lingüística para ayudarte a sacar el máximo partido de tu recurso lingüístico más valioso.

¿Cómo integramos todo esto en un proyecto de traducción al uso? Veamos un ejemplo.

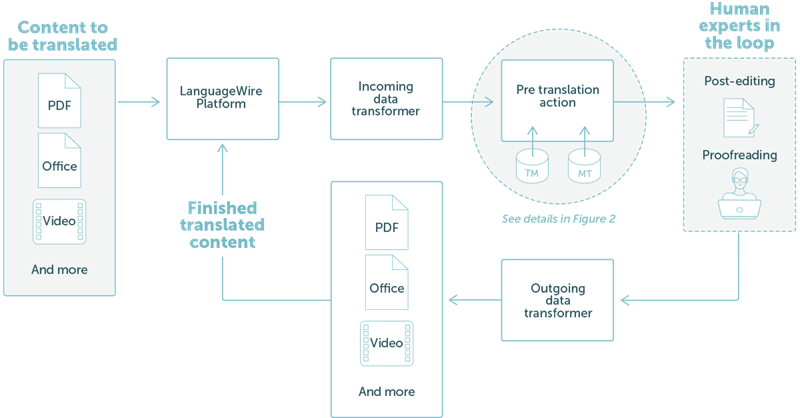

LanguageWire ofrece una solución totalmente integrada en nuestro ecosistema tecnológico. En la figura 1, a continuación, se muestran los diferentes pasos.

En este ejemplo, hemos tomado un flujo de trabajo sencillo en el que un cliente desea traducir archivos PDF o de Office. El usuario solo tiene que cargar los archivos de contenido a través del portal de proyectos de LanguageWire. A partir de ahí, todo se lleva a cabo de forma automática:

FIGURA 1: Un proyecto de traducción sencillo en la plataforma de LanguageWire

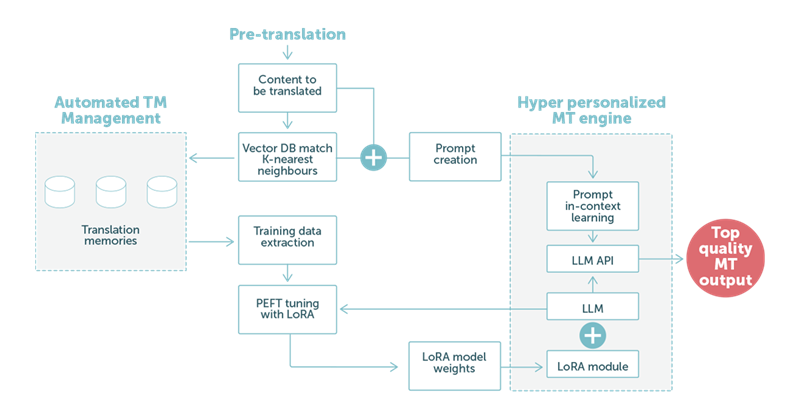

En el ejemplo 2, nos centramos en el paso de traducción previa utilizando la traducción automática basada en la tecnología LLM. Como podemos ver en la imagen 2 más abajo, los datos lingüísticos del cliente desempeñan una función fundamental.

FIGURA 2: Un ejemplo de traducción que utiliza un gran modelo de lenguaje con una mezcla de adaptaciones LoRA y mensajes de aprendizaje de contexto mejorados.

Cuando el LLM procesa nuestro mensaje especialmente diseñado, los pesos adaptados del módulo LoRa contribuirán a generar una traducción automática de alta calidad. Una vez finalizado, el resultado se desplaza automáticamente al siguiente paso del proceso. Normalmente, se trata de una tarea de posedición en la que interviene un traductor experto para obtener la máxima calidad final.

En pocas palabras: nuestros clientes pueden esperar una traducción automática aún mejor. La TA puede adaptarse automáticamente a contextos variables, por ejemplo, diferentes verticales de negocio y alinearse con el tono de voz esperado y la elección de palabras de esa vertical.

Esto no solo reducirá los gastos de posedición, sino que también aumentará la velocidad de entrega de las traducciones. También ampliará las posibilidades de utilizar directamente los resultados de la traducción automática sin la intervención de traductores expertos.

Como hemos dicho antes, los grandes modelos de lenguaje son muy flexibles. El equipo de IA de LanguageWire está investigando muchas otras áreas que podrían beneficiarse de la tecnología LLM.

Actualmente estamos investigando:

Evaluación automática de la calidad lingüística. El LLM podría revisar la traducción de un experto o el resultado de la traducción automática de otro modelo y valorar la calidad. Esto podría reducir considerablemente el coste de la revisión. La tecnología subyacente de estimación de la calidad de la traducción automática (MTQE, por sus siglas en inglés) también puede aplicarse a otros casos de uso.

Asistentes de redacción de contenidos. Utilizando una combinación de PEFT con LoRA y aprendizaje con pocos ejemplos, podemos personalizar el modelo LLM para centrarnos en tareas de creación de contenido. Un cliente puede proporcionar palabras clave y metadatos para que el modelo genere un texto con un tono de voz y una selección de palabras personalizados para la empresa.

Aplicación de una mayor adaptación del LLM con los datos de las bases de datos terminológicas.

Y esto no es todo. No pierdas de vista nuestro blog para enterarte de las publicaciones que haremos en las próximas semanas sobre la IA y el futuro de los LLM en LanguageWire.

Otros artículos de interés

Tu viaje hacia una experiencia en la gestión lingüística eficiente y sin complicaciones comienza aquí. Cuéntanos qué necesitas y te ofreceremos la solución perfecta adaptada a tu empresa.