Roeland Hofkens , Chief Product & Technology Officer, LanguageWire

Roeland Hofkens , Chief Product & Technology Officer, LanguageWire

Stora språkmodeller (LLM:er) har tagit världen med storm.

Vissa av dessa modeller, som OpenAI:s GPT-4 och Googles PaLM2, har tränats på flerspråkiga dataset och borde – åtminstone teoretiskt – kunna klara av maskinöversättning med bravur.

Men stämmer det verkligen? Hur utnyttjar vi den fulla potentialen hos stora språkmodeller för maskinöversättning? I denna tekniska fördjupning ska vi titta närmare på hur LLM:er arbetar med maskinöversättning och hur de kan integreras i ett Translation Management System (TMS).

De flesta av de nuvarande professionella maskinöversättningsverktygen, som Google Translate, bygger på neurala modeller med en transformationsstruktur. Dessa modeller är specialbyggda för en uppgift: maskinöversättning. De fungerar redan mycket bra för de uppgifter som krävs för översättning av generiskt innehåll. Men i en specialiserad verksamhetskontext kan de dock missa att använda rätt terminologi eller välja en stil som inte är optimal.

Därför kan det vara bra att skräddarsy dessa modeller med ytterligare företagsdata genom att träna dem så att de känner igen företagsspecifika termer och fraser. Modellen ”lär sig” använda ditt företags språkstil och specifika terminologi för att skapa bättre maskinöversättning med hjälp av olika metoder för kundanpassning

Stora språkmodeller bygger som regel också på transformationsarkitekturer. Jämfört med NMT-modellerna (Neural Machine Translations) i föregående avsnitt tränas de på avsevärt större textmassor och innehåller fler modellparametrar. LLM:er innehåller miljarder parametrar vilket kan jämföras med de enkla, tvåspråkiga NMT-modellerna som bara innehåller några hundra miljoner. Detta gör LLM:erna smidigare och ”smartare” när det gäller att tolka användarinstruktioner eller ”prompter”. Denna nya teknologi banar väg för en rad nya möjligheter när det gäller modellanpassning med företagsdata. Eftersom detta tillvägagångssätt är så kraftfullt föredrar jag att tala i termer av ”personalisering” istället för ”anpassning”. Låt oss titta närmare på hur denna personalisering fungerar.

Vid användning av LLM:er finns det i princip två metoder för finjustering av modellen så att den producerar bättre kvalitet i inferensskedet då den genererar sitt svar.

Låt oss först titta närmare på området parameterjustering.

Uppdateringen av parametrar i en LLM kan vara en överväldigande uppgift. Kom ihåg att även små LLM:er har miljarder parametrar. Uppdateringen av dessa är en dataintensiv och kostsam uppgift som vanligtvis är utom räckhåll för en vanlig konsument – kostnaden och komplexiteten är helt enkelt är för hög.

I maskinöversättningssyfte börjar vi som regel med en instruktionsjusterad LLM. Detta är en modell som har finjusterats för att vara mer hjälpsam och följa instruktioner, istället för att bara förutsäga nästa ord. Efter justeringen kommer modellen att prestera bättre på en rad olika sätt, till exempel vad gäller sammanfattning, indelning och maskinöversättning. Vi kommer att ge mer information om val av modell i kommande blogginlägg i denna serie.

De instruktionsjusterade LLM:erna är en bra utgångspunkt för ytterligare, kundspecifika optimeringar. Med hjälp av metoden PEFT (Parameter Efficient Fine-Tuning) kan vi finjustera en instruktionsjusterad modell med kunddata på ett kort och mer kostnadseffektivt sätt.

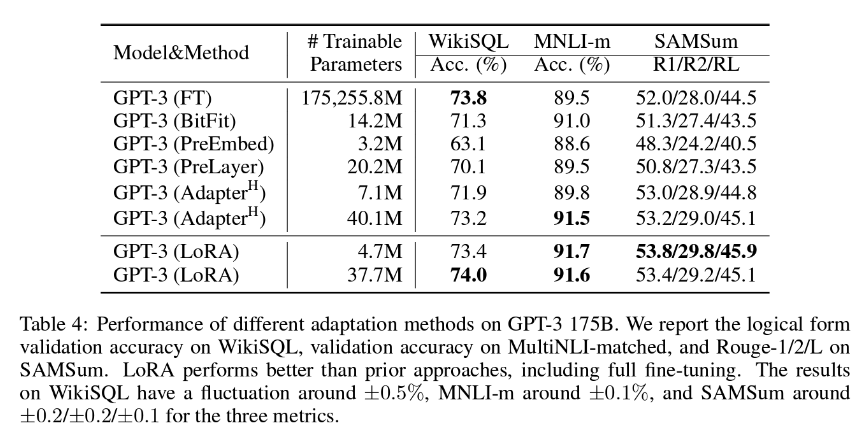

På LanguageWire prioriterar vi PEFT-metoden LoRA (Low-Rank Adaption), som vanligtvis innebär uppdatering av ca 1,4-2,0 % av modellvikterna. Detta innebär att anpassningsarbetet blir rimligt, men också överraskande effektivt. Som du kan se i tabellen nedan, drar författarna av LoRA-dokumentet slutsatsen att LoRA kan visa sig vara ännu effektivare än full justering av alla modellparametrar!

För bästa resultat av denna metod behöver vi tillgång till en stor mängd högkvalitativa träningsdata med matchande käll- och måltexter. Om du redan har skapat ett stort översättningsminne kan det förmodligen användas för detta ändamål. LanguageWires AI-team arbetar kontinuerligt med att hitta den optimala storleken på översättningsminnet för LoRA-justering.

Nu ska vi gå vidare till det andra tillvägagångssättet, kontextbaserad inlärning eller FSL (Few-Shot Learning).

Kontextbaserad inlärning är en metod där modellen lär sig under arbetets gång av ett fåtal exempel som introduceras av en specialdesignad prompt. Det kallas även för FSL (Few-Shot Learning).

När det gäller maskinöversättning fungerar FSL på följande sätt:

FSL för maskinöversättning har en positiv effekt vad gäller flöde, språkstil, och efterlevnaden av terminologi. Det krävs färre exempel att arbeta med, max tre till fem. Faktum är att större urvalsvolymer inte ökar effektiviteten, vilket innebär att inte är någon fördel att inkludera hela ditt översättningsminne i en enda prompt. Experiment har visat att LLM:er inte hanterar stora promptkontexter så bra och att kvaliteten på resultatet till och med kan försämras!

Det är genom att kombinera LoRA och FSL som vi kan optimera den stora språkmodellen på ett effektivt sätt, vilket i slutändan leder till hyperpersonaliserad maskinöversättning av högsta kvalitet.

Ingen av dessa tekniker skulle fungera utan en stor mängd högkvalitativa, uppdaterade tvåspråkiga textkorpusar i olika språkpar. Dina översättningsminnen är den optimala källan för detta dataset.

Men innan dessa kan användas finns det ett antal viktiga aspekter att beakta:

Använder du LanguageWires plattform sköts hanteringen av översättningsminnen automatiskt åt dig och du behöver inte göra något manuellt.

Om du har ett befintligt, externt översättningsminne som du vill använda tillsammans med våra plattforms- och maskinöversättningstjänster kan våra tekniker hjälpa dig med detta. LanguageWires tekniker har skapat API:er för import, rensningsskript och verktyg för språkkvalitetsbedömning som hjälper dig att få maximal nytta av dina mest värdefulla språkdata.

Så hur gör vi för att knyta ihop alla dessa trådar i samband med ett vanligt översättningsprojekt? Låt oss titta på ett exempel.

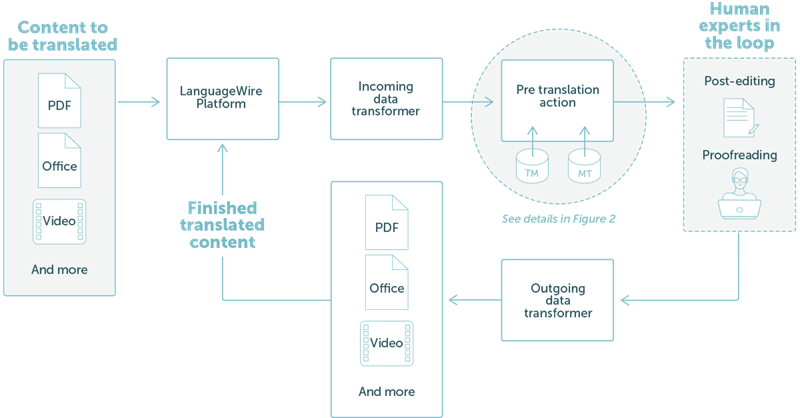

LanguageWire erbjuder en lösning som är helt integrerad i vårt ekosystem. Detta visas i övergripande steg i bild 1 nedan.

I det här exemplet har vi tagit ett enkelt arbetsflöde där en kund vill översätta PDF- eller Office-filer. Användaren laddar helt enkelt upp innehållsfilerna via LanguageWires projektportal. Därifrån sköts sedan allt automatiskt:

BILD 1: Resultat av ett enkelt översättningsprojekt på LanguageWires plattform

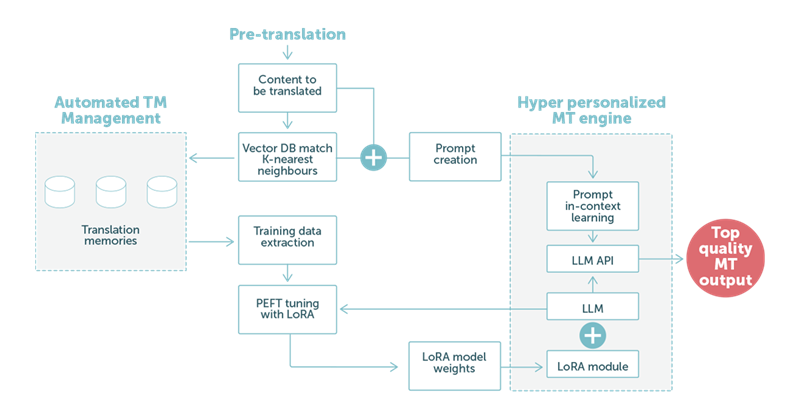

I exempel 2 fokuserar vi på föröversättningssteget med maskinöversättning baserad på LLM-teknologi. Som det framgår av bild 2 nedan spelar kundens språkdata en central roll.

BILD 2: Ett exempel på en översättning med en stor språkmodell (LLM) med en blandning av LoRA-anpassningar och kontextbaserade inlärningspromptar.

När vår specialdesignade prompt hanteras av LLM:en bidrar de anpassade vikterna i LoRA till att resultatet blir en maskinöversättning av högsta kvalitet. När processen är avslutad överförs detta resultat automatiskt till nästa steg i processen. Som regel är detta ett efterredigeringsuppdrag där en mänsklig expert kallas in för att säkerställa optimal slutkvalitet.

Sammanfattningsvis: våra kunder kan förvänta sig ännu bättre maskinöversättning. MT kan automatiskt anpassas efter olika kontexter, till exempel olika marknadsvertikaler, och anpassas efter den förväntade språkstilen och terminologin i den aktuella vertikalen.

Det minskar inte bara kostnaden för efterredigering, utan även leveranstiden för översättningarna. Det breddar även möjligheterna för direkt användning av MT-resultatet, utan att behöva mänskliga språkexperter behöver användas som mellanled.

Som vi tidigare nämnt är stora språkmodeller mycket flexibla. LanguageWires AI-team undersöker många andra områden som kan dra nytta av LLM-teknologin.

Just nu undersöker vi:

Automatisk LQA (språkkvalitetsbedömning). LLM:en kan kontrollera översättningen av en mänsklig språkexpert eller maskinöversättningen från en annan LLM och ge ett kvalitetsbetyg. Detta skulle kunna minska kostnaderna för korrekturläsning avsevärt. Den bakomliggande MTQE-teknologin (Machine Quality Estimation) kan också tillämpas på andra användningsfall.

Assistera vid framtagning av innehåll. Genom att kombinera PEFT med LoRA och FSL kan vi personalisera LLM-modellen så att den fokuserar på innehållsskapande. En kund kan tillhandahålla sökord och metadata som gör det möjligt för modellen att skapa en text med företagsanpassad språkstil och terminologi.

Gör ytterligare anpassning av LLM med data från termbaser.

Och det är inte allt, det finns mycket mer att hämta. Så håll under de närmaste veckorna utkik efter fler blogginlägg om AI och framtiden för LLM hos LanguageWire.

Andra intressanta artiklar

Din resa mot en kraftfull, sömlös och enkel lösning för att skapa flerspråkigt innehåll börjar här! Berätta om dina behov så skräddarsyr vi den perfekta lösningen för ditt företag.