Roeland Hofkens , Chief Product & Technology Officer, LanguageWire

Roeland Hofkens , Chief Product & Technology Officer, LanguageWire

Store språkmodeller (LLM-er) har tatt verden med storm.

Noen av disse modellene, som OpenAIs GPT-4 og Googles PaLM2, har blitt trent på et flerspråklig datasett og kan - i hvert fall i teorien – også være svært dgode til maskinoversettelse.

Men er dette faktisk tilfellet? Hvordan kan vi utnytte det fulle potensialet i store språkmodeller for maskinoversettelse? I denne artikkelen skal vi se på hvordan LLM fungerer i forbindelse med maskinoversettelse, og hvordan modellene kan integreres i et Et system for håndtering av oversettelser (TMS).

De fleste av dagens kommersielle verktøy for maskinoversettelse, som Google Translate, er basert på nevrale modeller med en transformasjonsarkitektur. Disse modellene er spesialbygd for én oppgave: maskinoversettelse. De fungerer allerede svært godt til oversettelse av generisk innhold. Men for smalere innholdstyper kan de mangle det riktige ordforrådet eller bruke en stil som ikke er optimal.

Derfor er det nyttig å tilpasse disse modellene med mer data og trene dem opp til å gjenkjenne personaliserte begreper og uttrykk. Ved hjelp av ulike tilpasningsteknikker lærer modellen å bruke bedriftens språklige tone og terminologi, noe som gir bedre maskinoversettelse.

Store språkmodeller er vanligvis også basert på transformasjonsarkitekturer. Sammenlignet med NMT-modellene (Neural Machine Translations) i forrige avsnitt er de imidlertid trent på mye større tekstmengder og inneholder flere modellparametere. LLM-er inneholder milliarder av parametere sammenlignet med noen få hundre millioner i enkle, tospråklige NMT-modeller. Dette gjør LLM-modellene mer fleksible og «smartere» når det gjelder tolkning av brukerinstruksjoner eller «ledetekster». Denne nye teknologien åpner opp for mange nye muligheter når det gjelder modelltilpasning med forretningsdata. Fordi denne tilnærmingen er så kraftfull, foretrekker jeg å snakke om «personalisering» i stedet for «tilpasning». La oss se nærmere på hvordan personalisering fungerer.

Ved bruk av LLM-er er det i utgangspunktet to tilnærminger for å finjustere modellen, slik at den gir bedre kvalitet ved differansetid – det øyeblikket da den genererer et svar.

La oss først undersøke parameterinnstilling.

Oppdatering av parameterne i en LLM kan være en krevende oppgave. Husk at selv små LLM-er har milliarder av parametere. Å oppdatere dem er en beregningsmessig svært kostbar oppgave som vanligvis er utenfor rekkevidden til en vanlig forbruker, ettersom kostnadene og kompleksiteten ved å gjøre det rett og slett er for høye.

For maskinoversettelse vil vi normalt starte med en instruksjonstilpasset LLM-modell Dette er en modell som er finjustert for å være mer nyttig og følge instruksjoner, i stedet for bare å forutsi de neste ordene. Etter innstillingen vil modellen fungere bedre med en rekke oppgaver som oppsummering, klassifisering og maskinoversettelse. Vi vil skrive om hvilken modell du bør velge i fremtidige blogginnlegg i denne serien.

De instruksjonstilpassede LLM-ene er et godt utgangspunkt for ytterligere, kundespesifikke optimaliseringer. Ved hjelp av en tilnærming kalt Parameter Efficient Fine-Tuning («PEFT») eller parametereffektiv finjustering, kan vi finjustere en instruert modell med kundedata på en raskere og mer kostnadseffektiv måte.

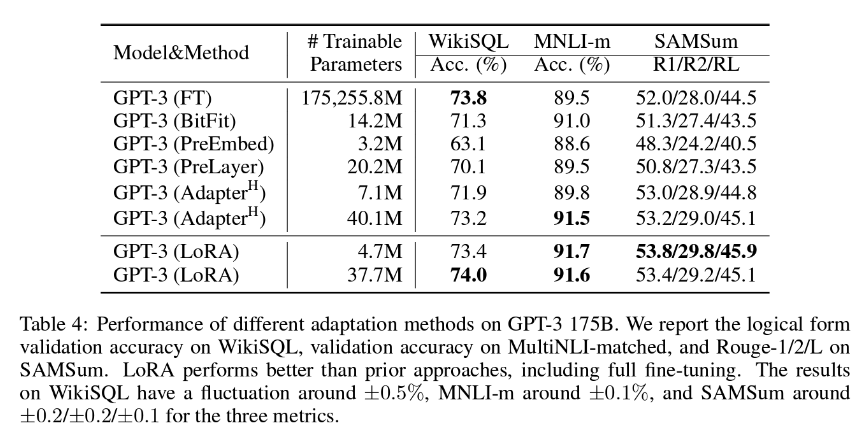

Hos LanguageWire er vår foretrukne PEFT-metode LoRA (Low-Rank Adaption), som vanligvis innebærer oppdatering av ca. 1,4–2,0 % av modellvektene. Dette betyr at tilpasningsarbeidet er rimelig, men også overraskende effektivt. Som du kan se i tabellen nedenfor, konkluderer forfatterne av LoRA-dokumentet med at LoRA kan vise seg å være enda mer effektiv enn full tilpasning av alle modellparametrene!

For å oppnå best mulig resultat med denne metoden må vi ha tilgang til en stor mengde opplæringsdata av høy kvalitet med matchende kilde- og måltekster. Hvis du allerede har et stort oversettelsesminne, kan det sannsynligvis brukes til dette formålet. LanguageWires KI-team jobber kontinuerlig med å finne den perfekte størrelsen på oversettelsesminne for LoRA-innstilling.

La oss nå se på den andre tilnærmingen, læring i kontekst eller «few-shot»-læring.

Læring i kontekst er en metode der modellen lærer underveis fra et lite antall eksempler introdusert av en spesielt utformet ledetekst. Det er også kjent som «few-shot»-læring.

I sammenheng med maskinoversettelse fungerer «few-shot»-læring slik:

«Few-shot»-læring for MT har en positiv innvirkning på tekstens flyt, språklig tone og terminologi i forhold til kildeteksten. Det krever færre eksempler å jobbe med, maksimalt tre til fem. Effektiviteten blir faktisk ikke bedre med større prøvestørrelser, slik at du ikke trenger å ta med hele oversettelsesminne i en enkelt ledetekst. Eksperimenter har vist at LLM-er ikke håndterer store ledetekst-kontekster så godt, og at kvaliteten på resultatene kan bli dårligere.

Det er gjennom å kombinere fordelene ved LoRA med few-shot-læring, at vi kan implementere effektive optimaliseringer i den store språkmodellen som til syvende og sist fører til hyperpersonaliserte maskinoversettelse av høy kvalitet.

Ingen av disse teknikkene ville fungere uten et stort sett med oppdaterte tospråklige tekstkorpora av høy kvalitet i ulike språkpar. Oversettelsesminne er en ideell kilde til dette datasettet.

Men før den kan brukes, må du vurdere flere viktige aspekter:

Hvis du bruker LanguageWire-plattformen, tar modulen for automatisk håndtering av oversettelsesminne seg av disse aspektene, og du trenger ikke å gjøre noe manuelt.

Hvis du har et eksternt oversettelsesminne som du ønsker å bruke sammen med vår plattform og våre tjenester for maskinoversettelse, kan våre teknikere gjøre dette mulig. LanguageWires tekniker har opprettet import-API-er, oppryddingsskript og verktøy for kvalitetsvurdering av språk for å hjelpe deg med å få mest mulig ut av din mest verdifulle språklige ressurs.

Så hvordan samler vi alt dette i et typisk oversettelsesprosjekt? La oss se på et eksempel.

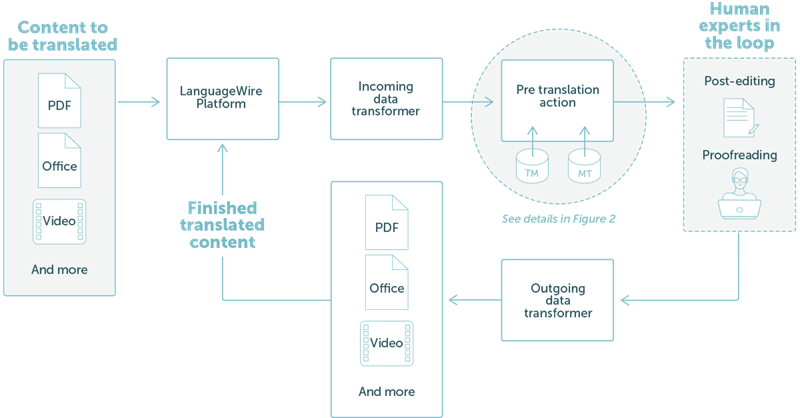

LanguageWire tilbyr en løsning som er fullt integrert i vårt teknologiske økosystem. Dette vises i trinn på høyt nivå i figur 1 nedenfor.

I dette eksempelet har vi tatt en enkel arbeidsflyt der en kunde ønsker å oversette PDF-filer eller Office-filer. Bruker laster opp en fil på LanguageWires prosjektportal. Derfra organiseres alt automatisk:

FIGUR 1: Resultatet av et oversettelseprosjekt på LanguageWire-plattformen

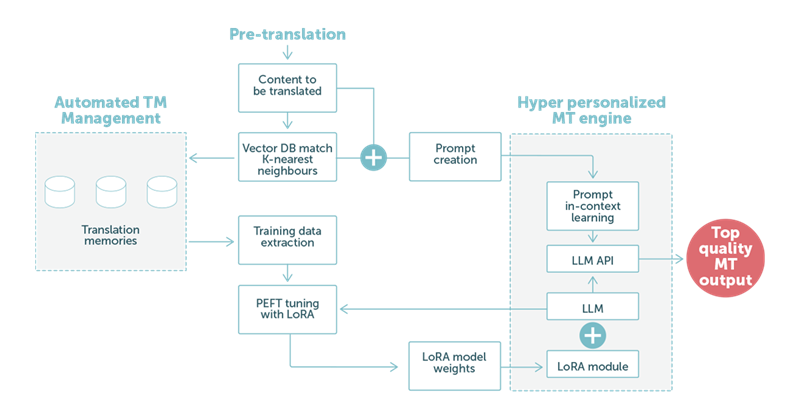

I eksempel 2 fokuserer vi på trinnet med forhåndsoversettelse ved hjelp av maskinoversettelse basert på LLM-teknologi. Som vist i figur 2 nedenfor, spiller de språklige dataene til kunde en sentral rolle.

FIGUR 2: Et eksempel på oversettelse ved hjelp av en stor språkmodell med en blanding av LoRA-tilpassinger og ledetekster for læring i kontekst.

Når vår spesialutviklede ledetekst håndteres av LLM, vil de tilpassede vektene i LoRA-modulen bidra til maskinoversettelse av høy kvalitet. Når dette er fullført, går den automatisk videre til neste trinn i prosessen. Vanligvis vil det være en etterredigeringsoppgave med en menneskelig ekspert for å oppnå maksimal sluttkvalitet.

Kort fortalt: Kundene våre kan forvente seg en enda bedre maskinoversettelse. MT kan tilpasse seg automatisk til ulike sammenhenger, for eksempel ulike forretningsvertikaler, og tilpasse seg den forventede språklig tonen og valg av ord i den vertikalen.

Ikke bare vil dette redusere kostnadene ved etterredigering, men det vil også øke hastigheten på leveranse av oversettelser. Det vil også gi større muligheter for å bruke MT-resultatene direkte, uten at menneskelige eksperter er involvert.

Som vi nevnte tidligere, er de store språkmodellene veldig fleksible. LanguageWires KI-team undersøker mange andre områder som kan dra nytte av LLM-teknologi.

Vi undersøker for tiden:

Automatisert kvalitetsvurdering av språk. LLM kan kontrollere oversettelse av en ekspert eller resultatet av maskinoversettelse fra en annen modell og gi en kvalitetspoengsum. Dette kan redusere kostnadene ved korrekturlesing betydelig. Bakenforliggende teknologi for estimering av kvaliteten på maskinoversettelser (MTQE) kan også brukes på andre områder.

Assistenter for innholdsskaping Ved å bruke en kombinasjon av PEFT og LoRA samt few shot-læring, kan vi personalisere LLM-modellen for å fokusere på innholdsproduksjon. En kunde kan levere nøkkelord og metadata som gjør at modellen kan generere en tekst som bruker en forretningstilpasset språklig tone og ordvalg.

Bruk ytterligere tilpasning av LLM med data fra termbaser.

Og det er mye mer i vente. Følg med for flere blogginnlegg i de kommende ukene om kunstig intelligens og fremtiden til LLM-er hos LanguageWire.

Andre nyttige artikler

Din reise til kraftig, sømløs språkstyring starter her! Fortell oss om behovene dine, så skreddersyr vi en perfekt løsning for bedriften din.